【实战演练】大规模机器学习:Spark MLlib入门

发布时间: 2024-06-26 15:22:55 阅读量: 80 订阅数: 124

# 2.1 Spark MLlib简介

Spark MLlib是一个基于Apache Spark的分布式机器学习库,它为大规模机器学习任务提供了丰富的算法和工具。

### 2.1.1 Spark MLlib的优势和适用场景

Spark MLlib具有以下优势:

- **分布式计算:**利用Spark的分布式计算框架,MLlib可以在大规模数据集上并行执行机器学习任务,显著提高计算效率。

- **丰富的算法库:**MLlib提供了一系列机器学习算法,涵盖分类、回归、聚类等常见任务,满足不同业务场景的需求。

- **易于使用:**MLlib提供了统一的API,简化了机器学习任务的开发和部署,降低了使用门槛。

MLlib适用于以下场景:

- 处理海量数据集的机器学习任务

- 需要高性能和低延迟的机器学习应用

- 涉及分布式计算和并行处理的机器学习项目

# 2. Spark MLlib入门

### 2.1 Spark MLlib简介

#### 2.1.1 Spark MLlib的优势和适用场景

Spark MLlib是Apache Spark生态系统中用于机器学习和数据分析的库。它提供了丰富的机器学习算法和工具,具有以下优势:

- **分布式计算:**Spark MLlib利用Spark的分布式计算能力,可以在大规模数据集上高效地执行机器学习任务。

- **易于使用:**Spark MLlib提供了一组高级API,使机器学习任务的开发变得简单。

- **可扩展性:**Spark MLlib可以轻松扩展到大型集群,处理海量数据。

- **与Spark生态系统集成:**Spark MLlib与Spark生态系统中的其他组件无缝集成,如Spark SQL、Spark Streaming和GraphX。

Spark MLlib适用于各种机器学习场景,包括:

- 大规模数据分类和回归

- 聚类和异常检测

- 推荐系统和自然语言处理

#### 2.1.2 Spark MLlib的架构和组件

Spark MLlib的架构包括以下组件:

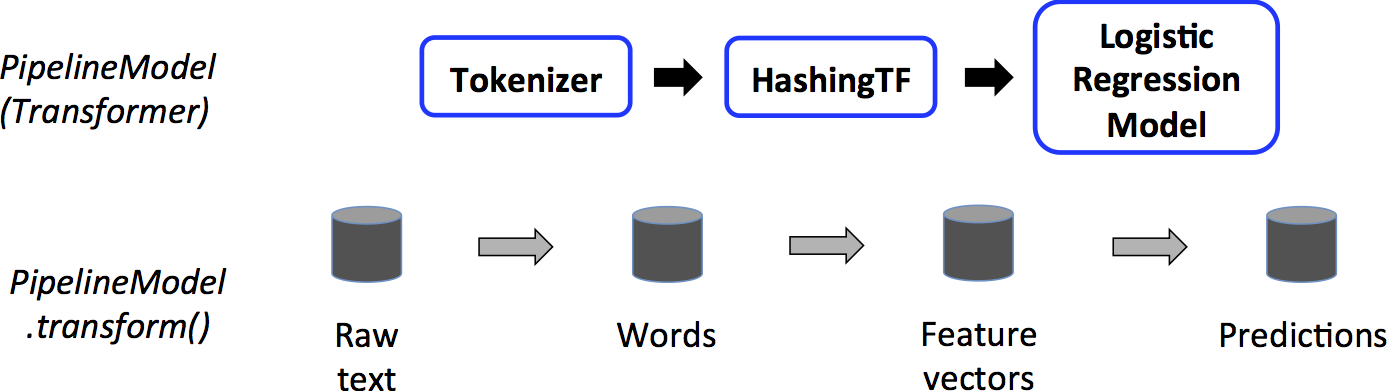

- **Pipeline:**管道是一种将机器学习任务分解为一系列步骤的机制。它使复杂的机器学习任务变得更容易管理和可重用。

- **Transformer:**Transformer是将输入数据转换为输出数据的组件。它可以用于数据预处理、特征工程和模型训练。

- **Estimator:**Estimator是训练机器学习模型的组件。它根据输入数据生成模型。

- **Model:**模型是训练后的机器学习模型。它可以用于对新数据进行预测。

- **Dataset:**数据集是表示机器学习数据表的组件。它提供了一组操作来加载、转换和处理数据。

### 2.2 Spark MLlib基本操作

#### 2.2.1 数据加载和预处理

Spark MLlib提供了一组数据加载器来加载各种格式的数据,如CSV、JSON和Parquet。数据加载后,可以使用Transformer进行预处理,如:

- **StandardScaler:**标准化数据,使其均值为0,标准差为1。

- **OneHotEncoder:**将分类特征转换为独热编码。

- **StringIndexer:**将字符串特征转换为索引。

#### 2.2.2 模型训练和评估

Spark MLlib提供了各种机器学习算法,如:

- **逻辑回归:**用于二分类和多分类。

- **决策树:**用于分类和回归。

- **支持向量机:**用于分类和回归。

模型训练后,可以使用评估器来评估模型的性能,如:

- **BinaryClassificationEvaluator:**用于二分类模型的评估。

- **MulticlassClassificationEvaluator:**用于多分类模型的评估。

- **RegressionEvaluator:**用于回归模型的评估。

#### 2.2.3 模型部署和使用

训练后的模型可以部署到生产环境中,用于对新数据进行预测。Spark MLlib提供了多种部署选项,如:

- **MLflow:**用于模型管理和部署的平台。

- **Spark Serving:**用于模型推理的分布式服务。

- **PMML:**用于模型交换的标准格式。

**代码示例:**

以下代码示例展示了如何使用Spark MLlib加载数据、训练模型并评估模型:

```python

# 加载数据

data = spark.read.csv("data.csv")

# 预处理数据

data = data.select("feature1", "feature2", "label")

data = StandardScaler().fit(data).transform(data)

# 训练模型

model = LogisticRegression().fit(data)

# 评估模型

evaluator = BinaryClassificationEvaluator()

accuracy = evaluator.evaluate(model.transform(data))

print("Accuracy:", accuracy)

```

**逻辑分析:**

该代码示例:

- 加载了CSV格式的数据。

- 预处理数据,将特征标准化。

- 训练了一个逻辑回归模型。

- 使用二分类评估器评估了模型的准确性。

# 3. Spark MLlib机器学习算法

### 3.1 分类算法

分类算法用于将数据点分配到预定义的类别中。Spark MLlib提供了多种分类算法,包括:

#### 3.1.1 逻辑回归

逻辑回归是一种广义线性模型,用于预测二元分类问题中的概率。它通过将输入特征与权重向量相乘,然后应用逻辑函数来计算输出概率。

```python

from pyspark.ml.classification import LogisticRegression

# 加载数据

data = spark.read.csv("data.csv")

# 训练逻辑回归模型

lr = LogisticRegression(maxIter=10)

model = lr.fit(data)

# 评估模型

predictions = model.transform(data)

accuracy = predictions.filter(predictions.prediction == predictions.label).count() / data.count()

print("Accuracy:", accuracy)

```

**逻辑分析:**

* `maxIter`参数指定最大迭代次数。

* `fit()`方法训练模型,返回训练后的模型。

* `transform()`方法使用训练后的模型对新数据进行预测,返回预测结果。

* `filter()`方法过滤出预测正确的行。

* `count()`方法计算过滤后的行数。

#### 3.1.2 决策树

决策树是一种树形结构,用于通过一系列规则对数据点进行分类。它从根节点开始,根据特征值将数据点分配到子节点,直到达到叶节点。

```python

from pyspark.ml.classification import DecisionTreeClassifier

# 加载数据

data = spark.read.csv("data.csv")

# 训练决策树模型

dt = DecisionTreeClassifier(maxDepth=5)

model = dt.fit(data)

# 评估模型

predictions = model.transform(data)

accuracy = predictions.filter(predictions.prediction == predictions.label).count() / data.count()

print("Accuracy:", accuracy)

```

**逻辑分析:**

* `maxDepth`参数指定决策树的最大深度。

* `fit()`方法训练模型,返回训练后的模型。

* `transform()`方法使用训练后的模型对新数据进行预测,返回预测结果。

* `filter()`方法过滤出预测正确的行。

* `count()`方法

0

0