【实战演练】强化学习项目:Deep Q-Learning实战

发布时间: 2024-06-26 15:19:54 阅读量: 82 订阅数: 125

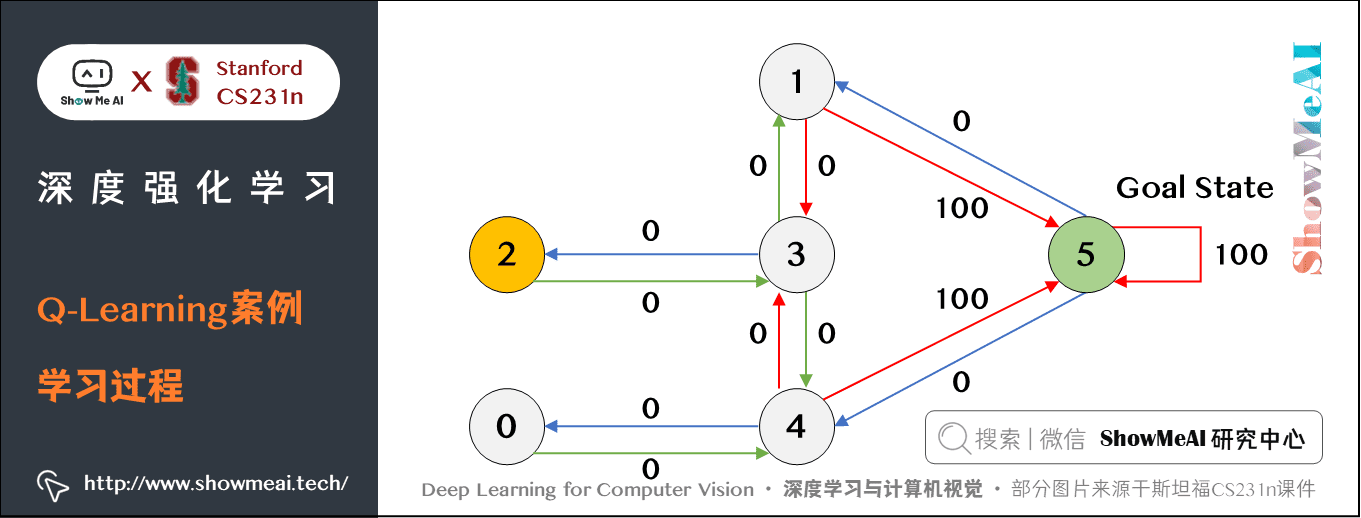

强化学习 Q-learning

# 1. **2.1 神经网络基础**

神经网络是一种机器学习模型,它由相互连接的节点组成,这些节点模仿人脑中的神经元。每个节点接收输入,执行计算,然后产生输出。这些节点分层排列,形成一个网络结构。

神经网络的层类型包括输入层、隐藏层和输出层。输入层接收原始数据,隐藏层执行复杂计算,输出层产生预测或决策。神经网络通过训练数据进行训练,训练过程中调整节点之间的权重和偏差,以最小化预测误差。

神经网络擅长处理复杂非线性数据,在图像识别、自然语言处理和强化学习等领域得到广泛应用。

# 2. Deep Q-Learning算法原理

### 2.1 神经网络基础

神经网络是一种受人类大脑启发的机器学习模型,它由相互连接的神经元组成。每个神经元接收输入,对其进行加权求和,然后应用激活函数产生输出。神经网络通过调整权重来学习模式和关系。

### 2.2 Q-Learning算法

Q-Learning是一种无模型强化学习算法,它使用值函数来估计每个状态-动作对的长期奖励。值函数Q(s, a)表示在状态s下执行动作a的预期总奖励。

Q-Learning算法通过迭代更新Q值来学习:

```python

Q(s, a) <- Q(s, a) + α * (r + γ * max_a' Q(s', a') - Q(s, a))

```

其中:

* α是学习率

* r是立即奖励

* γ是折扣因子

* s'是执行动作a后的下一个状态

### 2.3 Deep Q-Learning算法

Deep Q-Learning (DQN)是一种将神经网络与Q-Learning相结合的强化学习算法。它使用神经网络来近似Q值函数,从而能够处理高维状态空间。

DQN算法通过以下步骤进行:

1. **初始化神经网络:**初始化一个神经网络,输入为状态,输出为动作价值。

2. **经验回放:**将状态-动作-奖励-下一个状态四元组存储在经验回放池中。

3. **采样训练数据:**从经验回放池中随机采样一批四元组。

4. **计算目标值:**使用Q-Learning公式计算目标值y:

```

y = r + γ * max_a' Q(s', a')

```

5. **更新神经网络:**使用均方误差损失函数更新神经网络权重:

```

loss = (y - Q(s, a))^2

```

6. **重复步骤3-5:**重复采样和更新步骤,直到神经网络收敛。

### 代码示例

以下Python代码演示了DQN算法:

```python

import numpy as np

import tensorflow as tf

class DQN:

def __init__(self, state_dim, action_dim, learning_rate=0.001, gamma=0.9):

self.state_dim = state_dim

self.action_dim = action_dim

self.learning_rate = learning_rate

self.gamma = gamma

# 初始化神经网络

self.model = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(state_dim,)),

tf.keras.layers.Dense(action_dim)

])

# 优化器

self.optimizer = tf.keras.optimizers.Adam(learning_rate=learning_rate)

def predict(self, state):

return self.model.predict(state)

def update(self, state, action, reward, next_state):

# 计算目标值

target = reward + self.gamma * np.max(self.predict(next_state))

# 更新神经网络

with tf.GradientTape() as tape:

q_v

```

0

0