【基础】OpenAI Gym的安装与使用

发布时间: 2024-06-27 00:33:55 阅读量: 199 订阅数: 146

# 1. OpenAI Gym简介**

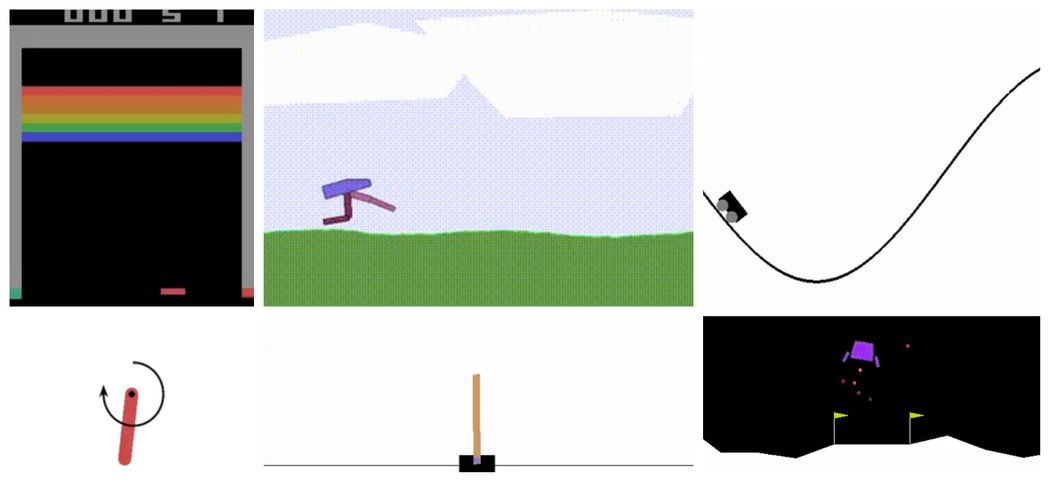

OpenAI Gym是一个用于强化学习研究和开发的开源库。它提供了一个标准化的环境集合,使研究人员能够轻松地比较和评估不同的强化学习算法。OpenAI Gym环境涵盖了各种任务,包括机器人控制、游戏和棋盘游戏。

该库的主要优点之一是其模块化设计,允许用户轻松地创建和自定义自己的环境。此外,OpenAI Gym还提供了许多工具和实用程序,使强化学习的开发和调试变得更加容易。它与流行的强化学习框架,如TensorFlow和PyTorch,无缝集成,使研究人员能够快速构建和训练复杂模型。

# 2. OpenAI Gym安装与配置

### 2.1 系统环境要求

在安装OpenAI Gym之前,需要确保系统满足以下环境要求:

- 操作系统:Linux、macOS或Windows

- Python版本:3.6或更高版本

- pip:Python包管理器

- Git:版本控制系统

### 2.2 安装OpenAI Gym

可以通过pip命令安装OpenAI Gym:

```bash

pip install gym

```

安装完成后,可以通过以下命令验证是否安装成功:

```bash

python -c "import gym"

```

如果安装成功,将不会出现任何错误信息。

### 2.3 验证安装

为了进一步验证安装,可以创建并运行一个简单的Gym环境。以下代码创建一个CartPole环境并运行它:

```python

import gym

# 创建CartPole环境

env = gym.make('CartPole-v1')

# 重复1000次

for i in range(1000):

# 获取环境状态

state = env.reset()

# 随机选择动作

action = env.action_space.sample()

# 执行动作并获取下一个状态、奖励和是否结束

next_state, reward, done, info = env.step(action)

# 如果结束,则重置环境

if done:

env.reset()

# 关闭环境

env.close()

```

如果代码运行成功,将输出环境交互信息,表明安装已成功。

### 代码逻辑分析

- `gym.make('CartPole-v1')`:创建CartPole环境,该环境是一个平衡杆问题。

- `env.reset()`:重置环境并返回初始状态。

- `env.action_space.sample()`:从动作空间中随机采样一个动作。

- `env.step(action)`:执行动作并返回下一个状态、奖励、是否结束和信息。

- `env.close()`:关闭环境,释放资源。

# 3. OpenAI Gym环境使用

### 3.1 创建和使用环境

OpenAI Gym提供了一个统一的接口来创建和使用各种环境。要创建环境,可以使用`gym.make()`函数。该函数接受环境名称作为参数,并返回一个环境对象。例如,要创建经典的CartPole环境,可以使用以下代码:

```python

import gym

env = gym.make('CartPole-v1')

```

创建环境后,可以使用`reset()`方法来重置环境并将其置于初始状态。`reset()`方法返回一个观测,表示环境的当前状态。

```python

observation = env.reset()

```

要与环境进行交互,可以使用`step()`方法。`step()`方法接受一个动作作为参数,并返回一个观测、奖励、是否终止以及其他信息。

```python

action = env.action_space.sam

```

0

0