【进阶】策略梯度方法(Policy Gradient)的原理

发布时间: 2024-06-27 01:18:36 阅读量: 84 订阅数: 146

强化学习策略梯度

# 2.1 强化学习的基本概念

强化学习是一种机器学习范式,它允许代理与环境交互并从其经验中学习。代理通过采取行动来影响环境,并根据其行动的结果获得奖励或惩罚。代理的目标是学习一个策略,该策略最大化其从环境中获得的长期奖励。

在强化学习中,环境通常被建模为马尔可夫决策过程 (MDP)。MDP 由以下元素组成:

- **状态空间**:代理可以处于的所有可能状态的集合。

- **动作空间**:代理可以在每个状态下采取的所有可能动作的集合。

- **转移函数**:描述代理在给定状态下采取给定动作后进入下一个状态的概率分布。

- **奖励函数**:描述代理在给定状态下采取给定动作后获得的奖励。

# 2. 策略梯度方法的理论基础

### 2.1 强化学习的基本概念

强化学习是一种机器学习范式,它允许代理在与环境交互的过程中学习最优行为。强化学习的基本概念包括:

- **状态(State):**环境的当前状态,通常由一组特征表示。

- **动作(Action):**代理可以采取的行动,以改变环境状态。

- **奖励(Reward):**代理执行动作后收到的反馈,表示动作的好坏。

- **价值函数(Value Function):**给定状态下采取特定动作的长期预期奖励。

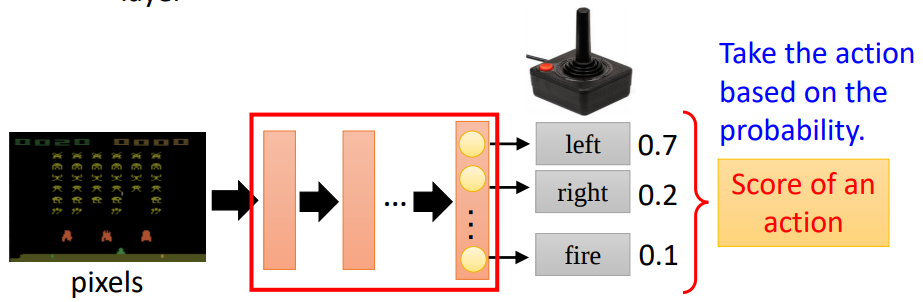

- **策略(Policy):**代理根据当前状态选择动作的函数。

### 2.2 策略梯度定理

策略梯度定理提供了计算策略梯度的公式,即策略对价值函数的梯度。它指出,策略梯度与期望奖励梯度成正比:

```

∇_θ J(θ) = E[∇_θ log π(a|s) Q(s, a)]

```

其中:

- θ 是策略的参数

- J(θ) 是策略的预期奖励

- π(a|s) 是在状态 s 下采取动作 a 的概率

- Q(s, a) 是在状态 s 下采取动作 a 的价值函数

### 2.3 策略梯度估计方法

由于期望奖励梯度通常难以直接计算,因此需要使用估计方法。常用的策略梯度估计方法包括:

- **蒙特卡罗方法:**通过模拟环境轨迹来估计期望奖励梯度。

- **时序差分学习(TD):**使用引导值函数来估计期望奖励梯度。

- **演员-评论家方法:**使用一个评论家网络来估计价值函数,并使用一个演员网络来更新策略。

#### 代码示例:蒙特卡罗策略梯度估计

```python

import numpy as np

def monte_carlo_policy_gradient(env, policy, num_episodes):

"""

蒙特卡罗策略梯度估计算法

参数:

env: 强化学习环境

policy: 策略

num_episodes: 训练回合数

"""

for episode in range(num_episodes):

# 初始化环境状态

state = env.reset()

# 生成环境轨迹

trajectory = []

while True:

# 根据策略选择动作

action = policy.sample_action(state)

# 执行动作并获取奖励

next_state, reward, done, _ = env.step(action)

# 记录状态-动作对和奖励

trajectory.append((state, action, reward))

# 如果回合结束,则更新策略

if done:

# 计算策略梯度

policy_gradient = 0

for state, action, reward in trajectory:

policy_gradient += np.nabla_log(policy.prob(action, state)) * reward

# 更新策略

policy.update(policy_gradient)

break

# 更新状态

state = next_state

```

#### 逻辑分析:

蒙特卡罗策略梯度估计算法通过模拟环境轨迹来估计期望奖励梯度。它通过记录状态-动作对和奖励,然后计算策略梯度并更新策略。该算法的优点是简单易懂,但缺点是计算量大,尤其是对于复杂的环境。

# 3.1 策略梯度方法在强化学习中的应用

策略梯度方法在强化学习领域得到了广泛的应用,特别是在解决回合制游戏和连续控制问题方面取得了显著的成功。

#### 3.1.1 回合制游戏

在回合制游戏中,代理通常需要根据当前状态选择一个动作,然后环境会根据代理的动作和当前状态做出反应,并返回一个新的状态和奖励。策略梯度方法可以用来学习一个策略,该策略可以最大化代理在回合制游戏中获得的长期奖励。

**代码块:**

```python

```

0

0