【进阶】模型自由(Model-free)强化学习的应用

发布时间: 2024-06-27 02:02:21 阅读量: 74 订阅数: 126

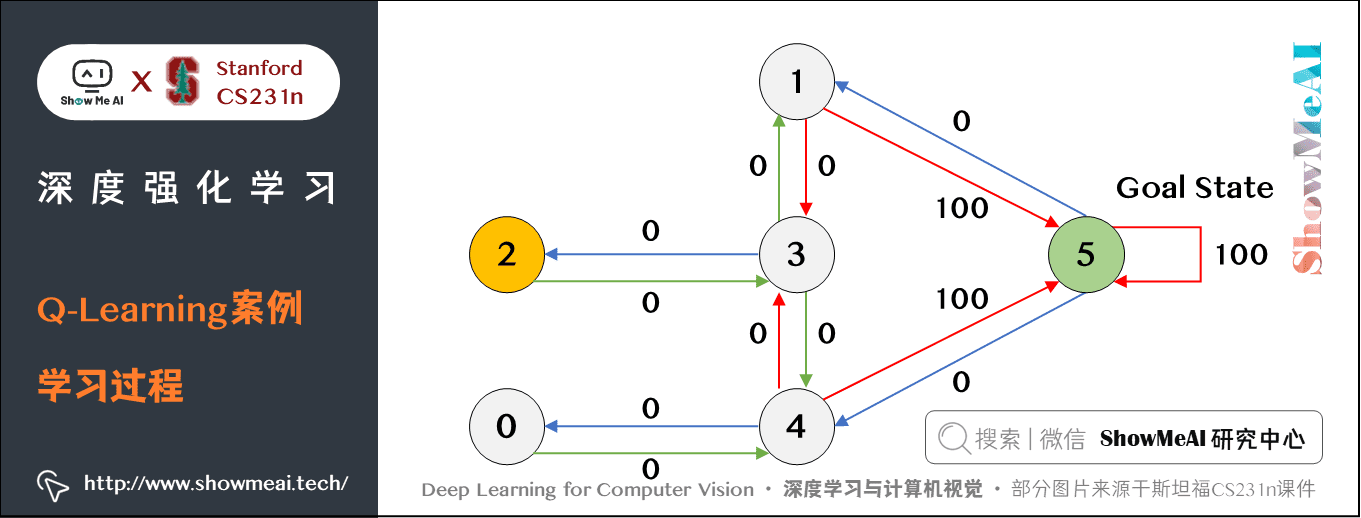

# 2.1 Q-learning算法

### 2.1.1 Q-learning算法的原理

Q-learning算法是一种无模型强化学习算法,它通过学习状态-动作值函数(Q函数)来估计动作的价值。Q函数表示在给定状态下执行特定动作的长期回报。

Q-learning算法的核心思想是迭代更新Q函数:

```

Q(s, a) = Q(s, a) + α * (r + γ * max_a' Q(s', a') - Q(s, a))

```

其中:

* `s`:当前状态

* `a`:当前动作

* `r`:当前回报

* `γ`:折扣因子

* `s'`:下一个状态

* `a'`:下一个动作

### 2.1.2 Q-learning算法的应用

Q-learning算法广泛应用于各种强化学习问题,例如:

* 游戏:训练AI玩游戏,如围棋、星际争霸

* 机器人:训练机器人导航、控制

* 金融:股票交易、风险管理

# 2. 模型自由强化学习算法

模型自由强化学习算法不需要显式地学习环境模型,而是直接从环境交互中学习最优策略。以下介绍三种常用的模型自由强化学习算法:

### 2.1 Q-learning算法

#### 2.1.1 Q-learning算法的原理

Q-learning算法是一种基于价值函数的强化学习算法。它通过学习状态-动作值函数(Q函数)来估计在每个状态下执行每个动作的长期回报。Q函数表示从给定状态执行给定动作后,未来获得的奖励的期望值。

Q-learning算法使用以下更新规则更新Q函数:

```python

Q(s, a) = Q(s, a) + α * (r + γ * max_a' Q(s', a') - Q(s, a))

```

其中:

* `s`:当前状态

* `a`:当前动作

* `r`:立即奖励

* `γ`:折扣因子(0~1)

* `s'`:下一个状态

* `a'`:下一个状态下所有可能动作中Q值最大的动作

* `α`:学习率(0~1)

#### 2.1.2 Q-learning算法的应用

Q-learning算法广泛应用于各种强化学习问题,包括:

* 游戏:围棋、星际争霸

* 机器人:移动机器人导航、工业机器人控制

* 金融:股票交易、风险管理

### 2.2 SARSA算法

#### 2.2.1 SARSA算法的原理

SARSA算法是Q-learning算法的变体,它使用当前状态和当前动作(state-action-reward-state-action)序列来更新Q函数。SARSA算法的更新规则如下:

```python

Q(s, a) = Q(s, a) + α * (r + γ * Q(s', a') - Q(s, a))

```

其中:

* `s`:当前状态

* `a`:当前动作

* `r`:立即奖励

* `γ`:折扣因子(0~1)

* `s'`:下一个状态

* `a'`:下一个状态下实际执行的动作

#### 2.2.2 SARSA算法的应用

SARSA算法常用于需要在线学习的强化学习问题,例如:

* 连续控制问题

* 探索性任务

* 博弈论

### 2.3 Actor-Critic算法

#### 2.3.1 Actor-Critic算法的原理

Actor-Critic算法是一种策略梯度算法,它将强化学习问题分解为两个子问题:

* **Actor**:学习策略,即在每个状态下选择动作的概率分布。

* **Critic**:评估策略,即计算策略在给定状态下执行动作的价值。

Actor-Critic算法使用Critic的价值函数来指导Actor更新策略,从而提高策略的性能。

#### 2.3.2 Actor-Critic算法的应用

Actor-Critic算法广泛应用于复杂强化学习问题,包括:

* 连续控制问题

* 多智能体系统

* 自然语言处理

# 3.1 模型自由强化学习在游戏中的应用

模型自由强化学习在游戏中得到了广泛的应用,特别是在需要智能决策和策略学习的环境中。以下介绍了模型自由强化学习在围棋和星际争霸中的具体应用。

#### 3.1.1 在围棋中的应用

围棋是一种复杂的策略游戏,需要玩家在广阔的棋盘上进行决策。模型自由强化学习算法,特别是深度神经网络强化学习(Deep Neural Network Reinforcement Learning,DNNRL),在围棋中取得了突破性的进展。

**AlphaGo**是谷歌开发的著名DNNRL算法,它通过自对弈的方式学习围棋策略。AlphaGo使用卷积神经网络(Convolutional Neural Network,CNN)来评估棋盘状态,并使用策略网络来选择下一步动作。

在2016年,AlphaGo以4:1击败了世界围棋冠军李世石,成为第一个击败人类职业棋手的计算机程序。AlphaGo的成功证明了模型自由强化学习在复杂策略游戏中学习和决策的强大能力。

#### 3.1.2 在星际争霸中

0

0