【基础】监督学习与无监督学习的区别

发布时间: 2024-06-25 02:16:34 阅读量: 77 订阅数: 115

# 2.1 监督学习的原理和特点

监督学习是一种机器学习方法,它利用标记数据(输入和输出值已知)来训练模型,使模型能够预测新数据的输出。监督学习算法从标记数据中学习输入和输出之间的关系,并建立一个函数来近似该关系。

监督学习的特点包括:

* **目标明确:**监督学习的目标是预测新数据的输出,而无需使用标记数据。

* **有标签数据:**监督学习需要使用标记数据来训练模型,其中输入和输出值都是已知的。

* **泛化能力:**监督学习算法通过学习标记数据中的模式,能够对新数据进行泛化,即对未见过的数据做出预测。

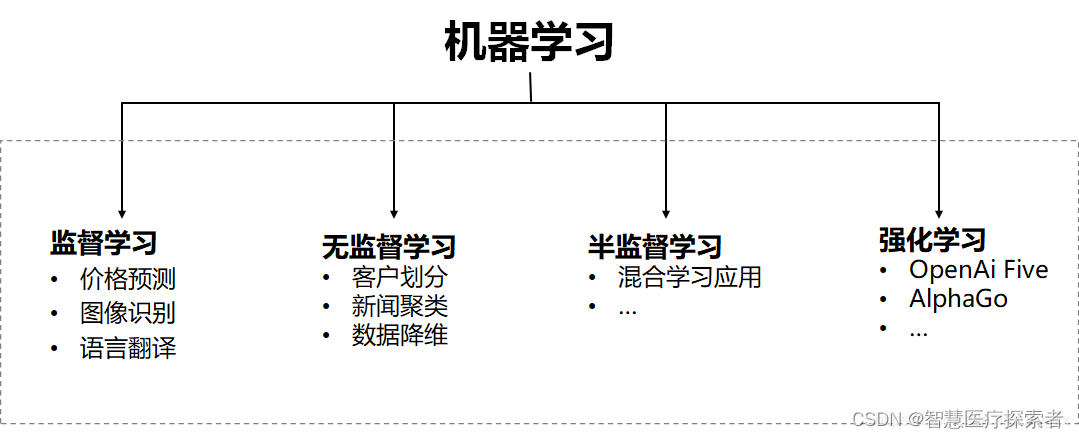

# 2. 监督学习与无监督学习的理论对比

### 2.1 监督学习的原理和特点

监督学习是一种机器学习方法,它使用带有标签的数据来训练模型。标签是与数据点关联的已知输出值。训练后的模型可以根据新输入的数据预测输出值。

#### 2.1.1 监督学习的类型

监督学习可分为两类:

- **分类问题:**预测输出值是一个离散类别(例如,垃圾邮件或非垃圾邮件)。

- **回归问题:**预测输出值是一个连续值(例如,房屋价格)。

#### 2.1.2 监督学习算法的评估指标

监督学习算法的性能可以通过以下指标评估:

- **准确率:**正确预测的样本数量除以总样本数量。

- **召回率:**正确预测的正例数量除以所有正例数量。

- **F1 分数:**准确率和召回率的调和平均值。

- **均方误差(MSE):**预测值与实际值之间的平方差的平均值。

### 2.2 无监督学习的原理和特点

无监督学习是一种机器学习方法,它使用没有标签的数据来训练模型。训练后的模型可以发现数据中的模式和结构。

#### 2.2.1 无监督学习的类型

无监督学习可分为两类:

- **聚类分析:**将数据点分组到具有相似特征的组中。

- **降维分析:**将高维数据投影到低维空间中,同时保留重要信息。

#### 2.2.2 无监督学习算法的评估指标

无监督学习算法的性能可以通过以下指标评估:

- **轮廓系数:**衡量聚类中数据点与所属簇的相似度和与其他簇的不相似度。

- **Davies-Bouldin 指数:**衡量簇之间的分离度。

- **方差解释率:**衡量降维算法保留原始数据方差的百分比。

# 3.1 监督学习的实践案例

#### 3.1.1 分类问题

**应用场景:**

监督学习在分类问题中广泛应用,例如:

- 垃圾邮件检测

- 图像识别

- 自然语言处理

**操作步骤:**

1. **收集和预处理数据:**收集包含特征和标签的数据集,并对数据进行预处理,如缺失值处理、数据标准化等。

2. **选择分类算法:**根据问题的具体情况选择合适的分类算法,如逻辑回归、决策树、支持向量机等。

3. **训练模型:**使用训练数据训练所选的分类算法,得到模型参数。

4. **评估模型:**使用测试数据评估模型的性能,计算准确率、召回率、F1值等指标。

5. **部署模型:**将训练好的模型部署到实际应用中,对新数据进行分类预测。

#### 3.1.2 回归问题

**应用场景:**

监督学习在回归问题中也广泛应用,例如:

- 房价预测

- 股票价格预测

- 天气预报

**操作步骤:**

1. **收集和预处理数据:**收集包含特征和目标值的连续值数据集,并对数据进行预处理。

2. **选择回归算法:**根据问题的具体情况选择合适的回归算法,如线性回归、多项式回归、支持向量回归等。

3. **训练模型:**使用训练数据训练所选的回归算法,得到模型参数。

4. **评估模型:**使用测试数据评估模型的性能,计算均方误差、平均绝对误差等指标。

5. **部署模型:**将训练好的模型部署到实际应用中,对新数据进行回归预测。

**代码示例:**

```python

# 导入必要的库

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

# 加载数据

data = pd.read_csv('data.csv')

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(data.drop('target', axis=1), data['target'], test_size=0.2)

# 创建线性回归模型

model = LinearRegression()

# 训练模型

model.fit(X_train, y_train)

# 评估模型

score = model.score(X_test, y_test)

print('模型得分:', score)

# 预测新数据

new_data = pd.DataFrame({'feature1': [10], 'feature2': [20]})

prediction = model.predict(new_data)

print('预测结果:', prediction)

```

**代码逻辑解读:**

1. 导入必要的库,包括数据处理库(pandas)、数据集分割库(sklearn.model_selection)和线性回归模型库(sklearn.linear_model)。

2. 加载数据并分割数据集为训练集和测试集。

3. 创建线性回归模型并使用训练数据训练模型。

4. 使用测试数据评估模型的性能,计算模型得分。

5. 使用新数据对模型进行预测。

**参数说明:**

* `train_test_split()`:数据集分割函数,`test_size`参数指定测试集比例。

* `LinearRegression()`:线性回归模型类。

* `fit()`:训练模型的方法,传入训练数据和标签。

* `score()`:评估模型性能的方法,传入测试数据和标签,返回模型得分。

* `predict()`:预测新数据的方法,传入新数据,返回预测结果。

# 4. 监督学习与无监督学习的算法选择

### 4.1 监督学习算法的选择

#### 4.1.1 线性模型

线性模型是监督学习中的一类经典算法,其基本假设是数据样本可以被线性函数很好地拟合。常见的线性模型包括:

- **线性回归:**用于预测连续型目标变量。

- **逻辑回归:**用于预测二分类问题中的目标变量。

- **支持向量机(SVM):**用于分类和回归问题,通过寻找最佳超平面将数据点分隔开。

**代码块:**

```python

# 导入线性回归模型

from sklearn.linear_model import LinearRegression

# 拟合线性回归模型

model = LinearRegression()

model.fit(X_train, y_train)

# 预测测试集数据

y_pred = model.predict(X_test)

```

**逻辑分析:**

- `LinearRegression()` 实例化一个线性回归模型。

- `fit()` 方法使用训练数据拟合模型。

- `predict()` 方法使用模型预测测试集数据。

**参数说明:**

- `X_train` 和 `X_test` 分别为训练集和测试集的特征数据。

- `y_train` 和 `y_test` 分别为训练集和测试集的目标变量。

#### 4.1.2 树模型

树模型是一种非线性模型,通过递归地将数据样本划分为更小的子集来构建决策树。常见的树模型包括:

- **决策树:**用于分类和回归问题,通过一系列决策规则将数据点分配到不同的叶节点。

- **随机森林:**由多个决策树组成的集成模型,通过对训练集进行采样和随机特征选择来提高准确性。

- **梯度提升决策树(GBDT):**通过迭代地拟合决策树来提高准确性,每个决策树都专注于纠正前一个树的错误。

**代码块:**

```python

# 导入决策树模型

from sklearn.tree import DecisionTreeClassifier

# 拟合决策树模型

model = DecisionTreeClassifier()

model.fit(X_train, y_train)

# 预测测试集数据

y_pred = model.predict(X_test)

```

**逻辑分析:**

- `DecisionTreeClassifier()` 实例化一个决策树分类器。

- `fit()` 方法使用训练数据拟合模型。

- `predict()` 方法使用模型预测测试集数据。

**参数说明:**

- `X_train` 和 `X_test` 分别为训练集和测试集的特征数据。

- `y_train` 和 `y_test` 分别为训练集和测试集的目标变量。

#### 4.1.3 神经网络

神经网络是一种深度学习模型,通过模拟人脑中的神经元连接来学习复杂的数据模式。常见的神经网络类型包括:

- **多层感知机(MLP):**由多个隐藏层组成的前馈神经网络,用于分类和回归问题。

- **卷积神经网络(CNN):**用于处理图像和视频数据,通过卷积和池化操作提取特征。

- **循环神经网络(RNN):**用于处理序列数据,通过记忆单元捕捉序列中的时间依赖性。

**代码块:**

```python

# 导入神经网络模型

from keras.models import Sequential

from keras.layers import Dense, Dropout

# 构建神经网络模型

model = Sequential()

model.add(Dense(128, activation='relu', input_dim=X_train.shape[1]))

model.add(Dropout(0.2))

model.add(Dense(1, activation='sigmoid'))

# 编译模型

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=32)

# 评估模型

scores = model.evaluate(X_test, y_test)

print("\n%s: %.2f%%" % (model.metrics_names[1], scores[1]*100))

```

**逻辑分析:**

- `Sequential()` 实例化一个顺序神经网络模型。

- `add()` 方法添加神经网络层,包括输入层、隐藏层和输出层。

- `compile()` 方法编译模型,指定损失函数、优化器和评估指标。

- `fit()` 方法使用训练数据训练模型。

- `evaluate()` 方法使用测试集评估模型。

**参数说明:**

- `X_train` 和 `X_test` 分别为训练集和测试集的特征数据。

- `y_train` 和 `y_test` 分别为训练集和测试集的目标变量。

- `epochs` 指定训练轮数。

- `batch_size` 指定每个训练批次的数据量。

### 4.2 无监督学习算法的选择

#### 4.2.1 聚类算法

聚类算法用于将数据样本分组到不同的簇中,每个簇包含具有相似特征的数据点。常见的聚类算法包括:

- **k-均值聚类:**将数据样本分配到 k 个簇中,每个簇的中心点由簇中所有数据点的平均值计算得到。

- **层次聚类:**通过逐步合并或分割簇来构建层次聚类树。

- **密度聚类:**基于数据样本的密度来识别簇,密度高的区域形成簇。

**代码块:**

```python

# 导入聚类算法

from sklearn.cluster import KMeans

# 拟合聚类模型

model = KMeans(n_clusters=3)

model.fit(X)

# 预测聚类标签

labels = model.predict(X)

```

**逻辑分析:**

- `KMeans()` 实例化一个 k-均值聚类器。

- `fit()` 方法使用数据样本拟合模型。

- `predict()` 方法使用模型预测数据样本的聚类标签。

**参数说明:**

- `X` 为待聚类的特征数据。

- `n_clusters` 指定聚类的簇数。

#### 4.2.2 降维算法

降维算法用于将高维数据投影到低维空间中,同时保留原始数据中的重要信息。常见的降维算法包括:

- **主成分分析(PCA):**通过线性变换将数据投影到主成分上,主成分是原始数据中方差最大的方向。

- **奇异值分解(SVD):**通过奇异值分解将数据分解为奇异值、左奇异向量和右奇异向量,低维投影可以通过截断奇异值来获得。

- **t 分布随机邻域嵌入(t-SNE):**一种非线性降维算法,通过最小化数据点之间的 t 分布相似性来将数据投影到低维空间中。

**代码块:**

```python

# 导入降维算法

from sklearn.decomposition import PCA

# 拟合降维模型

model = PCA(n_components=2)

model.fit(X)

# 降维数据

X_reduced = model.transform(X)

```

**逻辑分析:**

- `PCA()` 实例化一个 PCA 模型。

- `fit()` 方法使用数据样本拟合模型。

- `transform()` 方法使用模型将数据样本降维到低维空间中。

**参数说明:**

- `X` 为待降维的特征数据。

- `n_components` 指定降维后的维度数。

# 5. 监督学习与无监督学习的组合应用

### 5.1 半监督学习

#### 5.1.1 半监督学习的原理和方法

半监督学习是一种介于监督学习和无监督学习之间的机器学习方法。它利用少量标记数据和大量未标记数据来训练模型,从而提高模型的性能。

半监督学习的原理是利用未标记数据中的潜在结构信息来辅助标记数据的学习。通过对未标记数据进行聚类或降维等操作,可以挖掘出数据中的内在规律,从而为标记数据提供额外的信息。

半监督学习常用的方法包括:

- **自训练:**使用已标记数据训练一个初始模型,然后利用该模型对未标记数据进行预测,将预测置信度高的数据作为伪标记数据,并将其添加到标记数据集中,再重新训练模型。

- **协同训练:**训练多个模型,每个模型使用不同的数据子集和不同的学习算法。模型之间通过共享信息来相互改进,从而提高整体性能。

- **图半监督学习:**将数据表示为图结构,利用图中的拓扑结构信息来辅助学习。例如,可以将相似的未标记数据点连接起来,并利用已标记数据点对图进行分割,从而获得未标记数据的标签。

#### 5.1.2 半监督学习的应用场景

半监督学习广泛应用于以下场景:

- **数据稀疏:**当标记数据非常稀少时,半监督学习可以利用未标记数据来增强模型的泛化能力。

- **噪声数据:**当标记数据中存在噪声时,半监督学习可以利用未标记数据来平滑噪声的影响,提高模型的鲁棒性。

- **领域自适应:**当训练数据和测试数据分布不同时,半监督学习可以利用未标记的测试数据来适应新的领域,提高模型的泛化能力。

### 5.2 强化学习

#### 5.2.1 强化学习的原理和方法

强化学习是一种机器学习方法,它通过与环境交互来学习最优行为。在强化学习中,代理与环境交互,并根据其行为获得奖励或惩罚。代理的目标是学习一种策略,以最大化其在环境中获得的累积奖励。

强化学习的原理是通过试错来学习最优策略。代理通过探索环境,尝试不同的行为,并根据获得的奖励或惩罚来更新其策略。随着时间的推移,代理会逐渐学习到最优的行为,从而最大化其在环境中的累积奖励。

强化学习常用的方法包括:

- **值迭代:**计算状态和动作的价值函数,并基于价值函数选择最优动作。

- **策略梯度:**直接优化策略函数,以最大化累积奖励。

- **Q学习:**估计状态-动作对的Q值,并基于Q值选择最优动作。

#### 5.2.2 强化学习的应用场景

强化学习广泛应用于以下场景:

- **机器人控制:**机器人可以利用强化学习来学习最优的控制策略,以完成复杂的任务,如行走、抓取和导航。

- **游戏:**强化学习可以用于训练人工智能在游戏中击败人类玩家。

- **资源分配:**强化学习可以用于优化资源分配问题,如带宽分配和库存管理。

# 6.1 监督学习的发展趋势

### 6.1.1 深度学习的应用

深度学习是一种机器学习技术,它使用多层神经网络来学习数据的复杂特征。在过去几年中,深度学习取得了显著的进展,并在图像识别、自然语言处理和语音识别等领域取得了最先进的结果。

深度学习模型可以从大量数据中学习复杂的模式,这使得它们非常适合解决监督学习问题。例如,深度学习模型已被用于开发图像分类器,该分类器可以识别图像中的对象,以及自然语言处理模型,该模型可以理解和生成文本。

### 6.1.2 自动机器学习

自动机器学习 (AutoML) 是一种机器学习技术,它可以自动执行机器学习管道中的许多任务,例如数据预处理、特征工程和模型选择。这使得机器学习更容易被非专家使用,并可以帮助提高机器学习模型的性能。

AutoML 系统通常使用元学习技术来学习如何执行机器学习任务。元学习是一种机器学习技术,它允许模型学习如何学习新任务。这使得 AutoML 系统能够快速适应新数据集和任务,而无需进行大量的手动调整。

### 代码示例

以下 Python 代码展示了如何使用 TensorFlow 库训练深度学习模型来进行图像分类:

```python

import tensorflow as tf

# 加载数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.mnist.load_data()

# 归一化数据

x_train = x_train.astype('float32') / 255

x_test = x_test.astype('float32') / 255

# 创建模型

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10)

# 评估模型

model.evaluate(x_test, y_test)

```

0

0