【基础】交叉验证在模型评估中的重要性

发布时间: 2024-06-25 02:42:14 阅读量: 74 订阅数: 114

# 2.1 交叉验证的原理和类型

交叉验证是一种评估机器学习模型泛化能力的技术,其基本原理是将数据集划分为多个子集,并使用其中一个子集作为测试集,其余子集作为训练集。通过多次重复此过程,可以得到模型在不同数据集上的平均性能,从而更准确地反映模型的泛化能力。

交叉验证有不同的类型,最常见的类型包括:

- **K折交叉验证:**将数据集随机划分为K个大小相等的子集,每次使用一个子集作为测试集,其余K-1个子集作为训练集。

- **留一法交叉验证:**每次将一个样本作为测试集,其余样本作为训练集。

- **蒙特卡罗交叉验证:**随机多次划分数据集,每次使用不同的训练集和测试集。

# 2. 交叉验证的理论基础

### 2.1 交叉验证的原理和类型

**原理**

交叉验证是一种评估机器学习模型泛化能力的技术。它通过将数据集划分为多个子集(称为折),然后使用每个折作为测试集,而其余折作为训练集,反复训练和评估模型。通过对所有折的结果进行平均,可以得到模型在整个数据集上的泛化能力的估计值。

**类型**

根据数据集划分策略,交叉验证有以下主要类型:

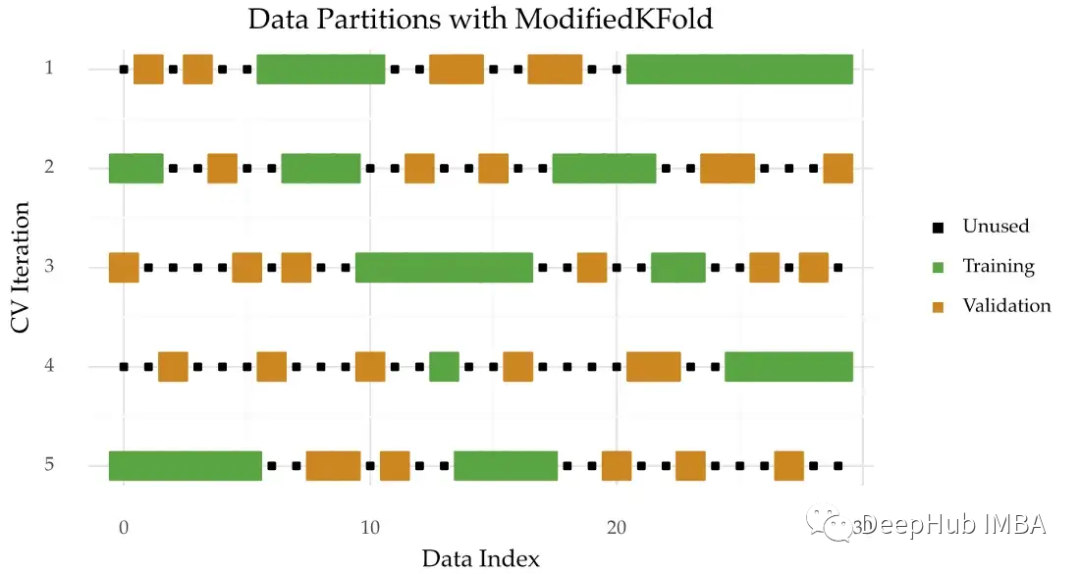

* **k 折交叉验证:**将数据集随机划分为 k 个大小相等的折,依次使用每个折作为测试集,其余折作为训练集。

* **留一法交叉验证:**将数据集划分为 n 个折,其中 n 为数据集中的样本数。依次使用每个样本作为测试集,其余样本作为训练集。

* **蒙特卡罗交叉验证:**随机多次划分数据集,每次划分使用不同的随机种子。每次划分后,使用一个折作为测试集,其余折作为训练集。

### 2.2 交叉验证的优缺点

**优点**

* **减少偏差:**通过多次训练和评估,交叉验证可以减少模型对特定训练集的偏差,从而得到更可靠的泛化能力估计。

* **提高效率:**与留出法相比,交叉验证可以更充分地利用数据集,提高模型训练效率。

* **选择最优模型:**通过比较不同交叉验证折上的模型性能,可以帮助选择最优的模型或模型参数。

**缺点**

* **计算成本:**交叉验证需要多次训练和评估模型,计算成本较高,尤其是对于大型数据集和复杂模型。

* **方差:**交叉验证结果可能受数据集划分策略和随机种子影响,导致方差较大。

* **过拟合风险:**如果交叉验证折太小,模型可能会过拟合于特定折,导致泛化能力估计过高。

**代码块**

```python

import numpy as np

from sklearn.model_selection import KFold

# 定义数据集

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8], [9, 10]])

y = np.array([0, 1, 0, 1, 0])

# 进行 5 折交叉验证

kf = KFold(n_splits=5, shuffle=True, random_state=123)

# 训练和评估模型

for train_index, test_index in kf.split(X, y):

# 划分训练集和测试集

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 训练模型

model.fit(X_train, y_train)

# 评估模型

score = model.score(X_test, y_test)

print("交叉验证折得分:", score)

# 计算交叉验证平均得分

avg_score = np.mean(scores)

print("交叉验证平均得分:", avg_score)

```

**逻辑分析**

该代码使用

0

0