【进阶】多任务学习方法及实践案例

发布时间: 2024-06-25 04:03:50 阅读量: 136 订阅数: 114

# 2.1 多任务学习的基本概念和原理

多任务学习(MTL)是一种机器学习范式,它允许模型同时学习多个相关任务。与传统单任务学习不同,MTL 利用任务之间的相关性来提高模型的泛化能力和效率。

MTL 的基本原理在于,相关任务共享潜在的特征或知识。通过同时学习这些任务,模型可以从每个任务中提取互补信息,从而增强其对所有任务的理解。例如,在计算机视觉中,目标检测和图像分割任务共享对图像中对象的几何形状和外观的理解。MTL 可以利用这种相关性来提高两个任务的性能。

# 2. 多任务学习理论基础

### 2.1 多任务学习的基本概念和原理

多任务学习(MTL)是一种机器学习范式,它通过同时学习多个相关任务来提高模型的性能。与传统的单任务学习不同,MTL 利用任务之间的相似性来共享知识,从而提升各个任务的泛化能力。

MTL 的基本原理在于:多个相关任务通常共享某些底层特征或知识。通过同时学习这些任务,模型可以从每个任务中提取有用的信息,并将其应用到其他任务中。这不仅可以提高模型的准确性,还可以减少训练时间和资源消耗。

### 2.2 多任务学习的分类和应用场景

MTL 根据任务之间的关系和共享知识的方式,可以分为以下几类:

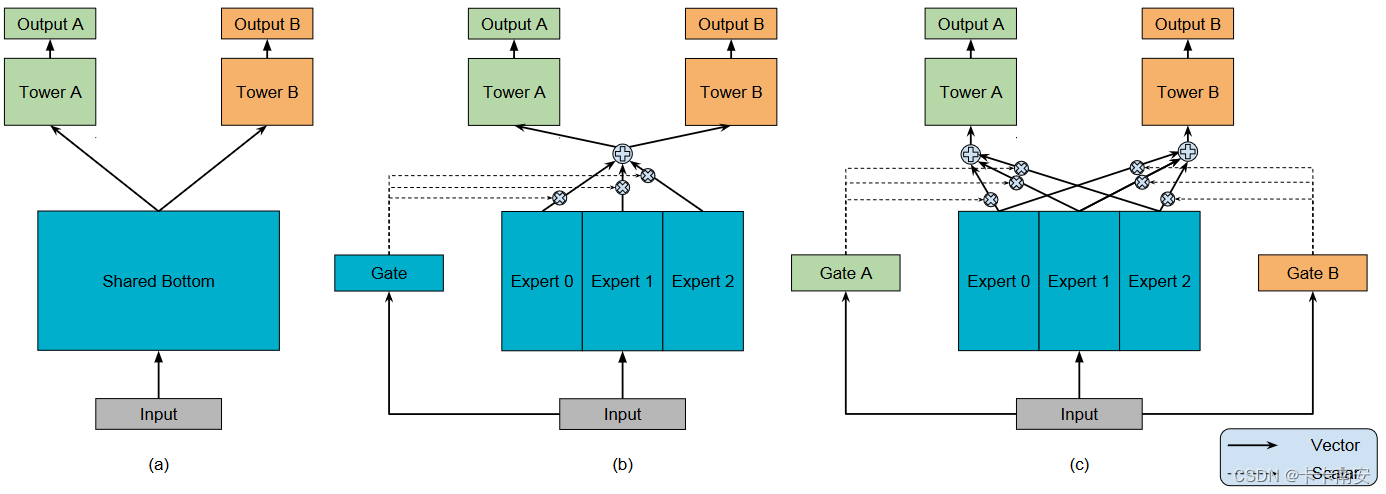

- **硬参数共享 MTL:**所有任务共享相同的模型参数,包括权重和偏差。这种方式可以有效地利用任务之间的相似性,但可能难以处理任务之间的差异性。

- **软参数共享 MTL:**任务共享部分模型参数,例如隐藏层或激活函数。这种方式可以兼顾任务之间的相似性和差异性,但参数共享的程度需要仔细调参。

- **任务关系学习 MTL:**任务之间不共享参数,而是通过学习任务之间的关系来提升性能。这种方式可以处理任务之间的复杂关系,但模型的训练和解释可能更困难。

MTL 在许多领域都有广泛的应用,包括:

- **计算机视觉:**目标检测、图像分割、人脸识别

- **自然语言处理:**文本分类、情感分析、机器翻译

- **语音识别:**语音识别、说话人识别

- **推荐系统:**商品推荐、电影推荐

### 代码示例

考虑以下代码块,它展示了硬参数共享 MTL 的一个简单示例:

```python

import tensorflow as tf

# 定义共享模型参数

shared_weights = tf.Variable(tf.random.normal([10, 10]))

shared_bias = tf.Variable(tf.random.normal([10]))

# 定义两个任务的模型

task1_model = tf.keras.Sequential([

tf.keras.layers.Dense(10, activation='relu', kernel_initializer=shared_weights, bias_initializer=shared_bias),

tf.keras.layers.Dense(1)

])

task2_model = tf.keras.Sequential([

tf.keras.layers.Dense(10, activation='relu', kernel_initializer=shared_weights, bias_initializer=shared_bias),

tf.keras.layers.Dense(1)

])

# 编译模型

task1_model.compile(optimizer='adam', loss='mse')

task2_model.compile(optimizer='adam', loss='mse')

# 训练模型

task1_model.fit(x_train1, y_train1, epochs=10)

task2_model.fit(x_train2, y_train2, epochs=10)

```

### 代码逻辑分析

在这个示例中:

- `shared_weights` 和 `shared_bias` 定义了共享的模型参数。

- `task1_model` 和 `task2_model` 是两个任务的模型,它们共享相同的参数。

- `task1_model.fit()` 和 `task2_model.fit()` 分别训练两个任务的模型。

通过共享参数,两个任务可以从彼此的训练中受益,从而提高整体性能。

# 3. 多任务学习实践指南

### 3.1 多任务学习算法选择和调参

#### 算法选择

选择多任务学习算法时,需要考虑以下因素:

- **任务相关性:**任务之间的相关性决定了是否适合使用多任务学习。高相关性任务可以从共享表示中受益,而低相关性任务可能需要单独处理。

- **模型复杂度:**算法的复杂度影响训练和推理时间。对于资源受限的场景,需要选择轻量级的算法。

- **可解释性:**某些算法比其他算法更易于解释,这对于理解模型行为和进行故

0

0