【进阶】自然语言处理中的词嵌入技术

发布时间: 2024-06-25 04:12:45 阅读量: 65 订阅数: 115

# 2.1 词嵌入的概念和发展

词嵌入是一种将单词表示为低维向量的技术,它可以捕捉单词的语义和语法信息。词嵌入的概念最早可以追溯到上世纪 80 年代,当时研究人员开始探索使用神经网络来表示单词。

在 2003 年,Bengio 等人提出了神经语言模型,该模型使用神经网络来预测文本中的下一个单词。该模型使用了一个隐藏层,其中每个神经元表示一个单词。隐藏层的权重矩阵可以被视为单词的词嵌入。

2008 年,Mikolov 等人提出了 Word2Vec 模型,该模型使用浅层神经网络来学习单词的词嵌入。Word2Vec 模型的出现标志着词嵌入技术的发展进入了一个新的阶段。Word2Vec 模型简单高效,并且能够学习到高质量的词嵌入。

近年来,词嵌入技术得到了广泛的研究和应用。研究人员提出了各种新的词嵌入模型,例如 GloVe 模型、ELMo 模型和 BERT 模型。这些模型进一步提高了词嵌入的质量,并扩展了词嵌入的应用范围。

# 2. 词嵌入理论基础

### 2.1 词嵌入的概念和发展

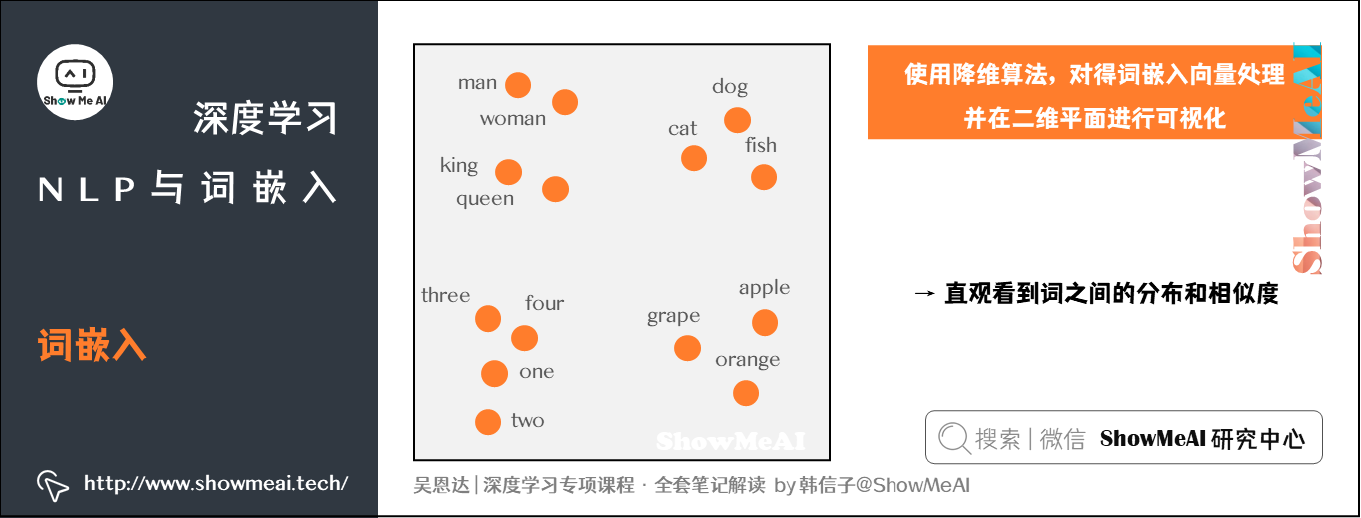

词嵌入是一种将单词表示为低维稠密向量的技术。它将单词的语义信息和语法信息编码到向量中,使得相似语义的单词在向量空间中距离较近。词嵌入的出现极大地促进了自然语言处理的发展,为各种NLP任务提供了有效的特征表示。

词嵌入的概念最早可以追溯到上世纪60年代的分布式语义模型(DSM)。DSM假设语义相似的单词在文本语料库中会出现在相似的上下文中。基于这一假设,研究人员提出了各种方法来提取单词的分布式表示,如潜在语义分析(LSA)和奇异值分解(SVD)。

### 2.2 词嵌入的数学原理

#### 2.2.1 向量空间模型

词嵌入的数学原理基于向量空间模型。在向量空间模型中,每个单词被表示为一个固定长度的向量,向量的每个维度对应单词的一个语义或语法特征。相似语义的单词在向量空间中距离较近,而语义不同的单词距离较远。

#### 2.2.2 矩阵分解方法

词嵌入的训练通常采用矩阵分解的方法。给定一个单词-上下文共现矩阵,矩阵分解方法将该矩阵分解为两个低秩矩阵,一个单词矩阵和一个上下文矩阵。单词矩阵中的每一行对应一个单词的向量表示,而上下文矩阵中的每一行对应一个上下文的向量表示。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 单值分解(SVD)

word_context_matrix = np.random.rand(1000, 100) # 单词-上下文共现矩阵

svd = TruncatedSVD(n_components=100) # 设定的维度

svd.fit(word_context_matrix)

word_embeddings = svd.components_ # 单词嵌入

context_embeddings = svd.transform(word_context_matrix) # 上下文嵌入

```

**逻辑分析:**

该代码块使用单值分解(SVD)方法对单词-上下文共现矩阵进行分解。分解后得到两个低秩矩阵:单词嵌入矩阵和上下文嵌入矩阵。单词嵌入矩阵中的每一行对应一个单词的向量表示,而上下文嵌入矩阵中的每一行对应一个上下文的向量表示。

**参数说明:**

* `n_components`:指定分解后的矩阵维度。

# 3.1 词嵌入的训练技术

**3.1.1 Word2Vec模型**

Word2Vec是一种由谷歌开发的词嵌入模型,它通过神经网络来学习词语的分布式表示。Word2Vec有两种训练模式:连续词袋(CBOW)和跳字(Skip-gram)。

**CBOW模式**

在CBOW模式中,给定一个中心词,模型会预测其周围的上下文词。通过最小化预测误差,模型可以学习中心词的词向量。

```python

import gensim

sentences = [['this', 'is', 'a', 'sentence'], ['this', 'is', 'another', 'sentence']]

# 训练CBOW模型

model = gensim.models.Word2Vec(sentences, min_count=1)

# 获取中心词"this"的词向量

this_vector = model.wv['this']

```

**Skip-gram模式**

在Skip-gram模式中,给定一个中心词,模型会预测其附近的多个上下文词。与CBOW不同,Skip-gram可以捕获更远距离的语义关系。

```python

# 训练Skip-gram模型

model = gensim.models.Word2Vec(sentences, min_count=1, sg=1)

# 获取中心词"this"的词向量

this_vector = model.wv['this']

```

**3.1.2 GloVe模型**

GloVe(Global Vectors for Word Representation)是一种基于全局矩阵分解的词嵌入模型。它通过最小化单词共现矩阵中的非零元素的加权平方误差来学习词向量。

```python

import glove

# 训练GloVe模型

glove_model = glove.Glove(sentences, dim=100)

# 获取中心词"this"的词向量

this_vector = glove_model.word_vectors['this'

```

0

0