【进阶】长短时记忆网络(LSTM)原理与实践

发布时间: 2024-06-25 03:27:55 阅读量: 86 订阅数: 114

# 1. 长短时记忆网络(LSTM)简介**

长短时记忆网络(LSTM)是一种循环神经网络(RNN),专为解决RNN在处理长期依赖关系方面的不足而设计。LSTM网络通过引入记忆单元和门控机制,能够有效地捕获和利用序列数据中的长期信息。

LSTM网络的记忆单元是一个特殊的神经元,它可以存储和更新长期信息。门控机制包括输入门、遗忘门和输出门,它们控制着信息流入、遗忘和输出记忆单元的过程。这些机制使LSTM网络能够选择性地学习和保留相关信息,同时丢弃不相关的信息。

# 2. LSTM网络的理论基础

### 2.1 LSTM网络的结构和原理

#### 2.1.1 LSTM网络的单元结构

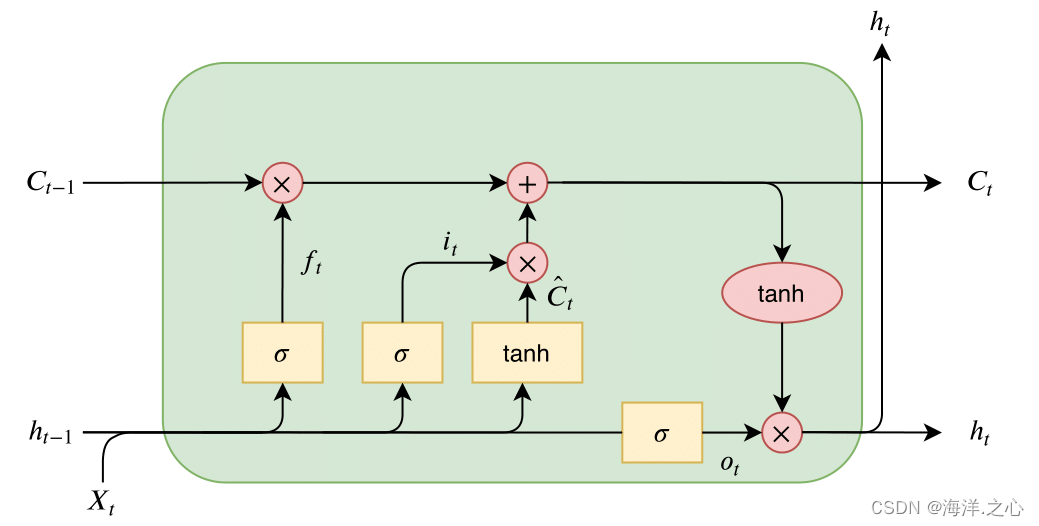

LSTM(长短期记忆网络)是一种特殊类型的循环神经网络(RNN),专门设计用于学习和处理长期依赖关系。与传统RNN不同,LSTM网络具有一个特殊的单元结构,称为LSTM单元,该单元能够有效地存储和访问长期记忆。

LSTM单元由四个主要部分组成:

1. **遗忘门:**决定从前一个时间步遗忘哪些信息。

2. **输入门:**决定从当前输入中获取哪些信息。

3. **记忆单元:**存储长期记忆。

4. **输出门:**决定从记忆单元中输出哪些信息。

#### 2.1.2 LSTM网络的记忆机制

LSTM网络的记忆机制是其关键特性。它允许网络在时间序列中学习和存储长期依赖关系。LSTM单元通过其门控机制实现记忆:

1. **遗忘门:**计算一个遗忘向量,该向量确定前一个时间步的记忆单元中哪些信息应该被遗忘。

2. **输入门:**计算一个输入向量,该向量确定当前输入中哪些信息应该被添加到记忆单元中。

3. **记忆单元:**更新其状态,将遗忘的信息删除,并将新的信息添加到记忆单元中。

4. **输出门:**计算一个输出向量,该向量确定记忆单元中哪些信息应该输出到下一个时间步。

### 2.2 LSTM网络的训练和优化

#### 2.2.1 LSTM网络的训练算法

LSTM网络的训练通常使用反向传播算法。反向传播算法通过计算误差梯度并更新网络权重来训练神经网络。对于LSTM网络,反向传播算法的计算过程略有不同,因为它涉及到时间步之间的依赖关系。

#### 2.2.2 LSTM网络的优化方法

为了提高LSTM网络的训练效率和性能,可以使用各种优化方法,例如:

1. **梯度裁剪:**限制梯度的幅度,以防止梯度爆炸。

2. **正则化:**添加正则化项以防止过拟合。

3. **学习率衰减:**随着训练的进行,逐渐降低学习率。

4. **批量归一化:**对网络的激活值进行归一化,以提高稳定性。

# 3. LSTM网络的实践应用

### 3.1 自然语言处理

LSTM网络在自然语言处理领域有着广泛的应用,主要包括文本分类和机器翻译两个方面。

#### 3.1.1 文本分类

文本分类是指将文本数据划分为预定义类别。LSTM网络通过学习文本序列中的长期依赖关系,可以有效地提取文本特征,

0

0