【基础】回归预测模型:MATLAB岭回归和Lasso回归

发布时间: 2024-05-22 12:38:44 阅读量: 120 订阅数: 283

回归分析(matlab)

# 1. 回归预测模型概述**

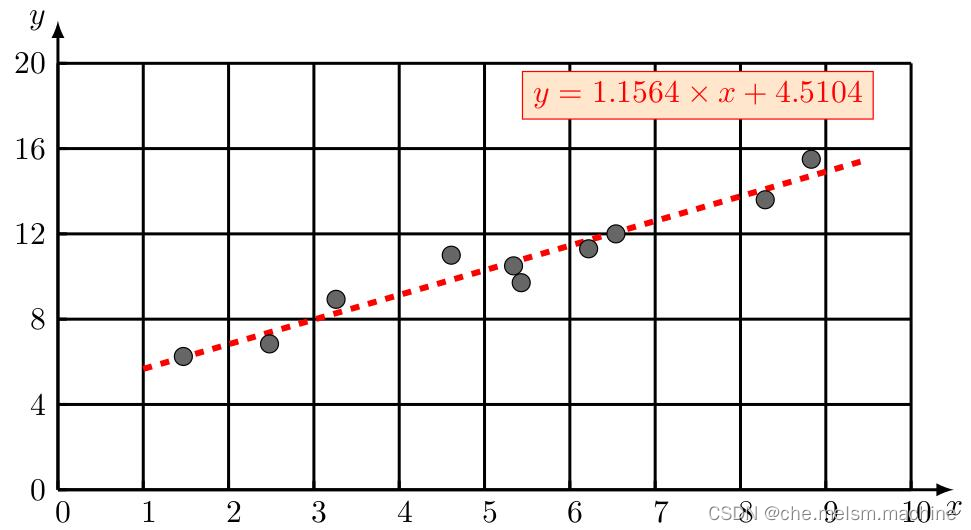

回归预测模型是一种统计学习模型,用于预测连续型变量(因变量)与一个或多个自变量(自变量)之间的关系。回归模型通过拟合一条曲线或超平面来描述因变量与自变量之间的关系,从而可以根据自变量的值预测因变量的值。

回归预测模型在各个领域都有广泛的应用,例如:

* 房价预测

* 股票价格预测

* 医疗诊断

* 经济预测

# 2. MATLAB岭回归

### 2.1 岭回归原理和数学推导

岭回归是一种正则化回归模型,它通过在损失函数中添加一个正则化项来解决普通最小二乘法回归中的过拟合问题。正则化项惩罚模型中系数的绝对值,从而迫使模型更简单,避免过拟合。

岭回归的损失函数如下:

```

J(w) = (1/2) * ||y - Xw||^2 + (lambda/2) * ||w||^2

```

其中:

* `y` 是目标变量

* `X` 是特征矩阵

* `w` 是模型系数

* `lambda` 是正则化参数

### 2.2 岭回归参数估计和正则化参数选择

#### 2.2.1 最小二乘法估计

岭回归的系数可以通过最小化损失函数来估计。使用最小二乘法,系数估计值可以表示为:

```

w = (X^T X + lambda * I)^-1 X^T y

```

其中:

* `I` 是单位矩阵

#### 2.2.2 正则化参数选择方法

正则化参数 `lambda` 的选择至关重要。它控制着正则化项的强度,从而影响模型的复杂度。

常用的正则化参数选择方法有:

* 交叉验证:将数据分成多个子集,使用不同的子集进行训练和验证,选择在验证集上性能最佳的 `lambda` 值。

* L曲线:绘制损失函数和正则化项之和随 `lambda` 变化的曲线,选择拐点处的 `lambda` 值。

### 2.3 岭回归的MATLAB实现

#### 2.3.1 数据准备和模型训练

```matlab

% 加载数据

data = load('data.mat');

% 分割数据

X = data.X;

y = data.y;

% 标准化数据

X = (X - mean(X)) ./ std(X);

y = (y - mean(y)) ./ std(y);

% 创建岭回归模型

lambda = 0.1; % 正则化参数

model = ridge(X, y, lambda);

```

#### 2.3.2 模型评估和结果解释

```matlab

% 预测

y_pred = predict(model, X);

% 评估模型

mse = mean((y_pred - y).^2); % 均方误差

rmse = sqrt(mse); % 均方根误差

r2 = 1 - sum((y_pred - y).^2) / sum((y - mean(y)).^2); % R^2 得分

% 打印结果

fprintf('均方误差:%.4f\n', mse);

fprintf('均方根误差:%.4f\n', rmse);

fprintf('R^2 得分:%.4f\n', r2);

```

# 3. MATLAB Lasso回归

### 3.1 Lasso回归原理和数学推导

Lasso回归(Least Absolute Shrinkage and Selection Operator Regression)是一种线性回归模型,它通过在目标函数中添加一个L1正则化项来对回归系数进行惩罚。与岭回归不同,Lasso回归的正则化项是绝对值,这会导致某些回归系数直接变为0,从而实现特征选择。

Lasso回归的目标函数为:

```

min_β (1/2n) ||y - Xβ||^2 + λ||β||_1

```

其中:

* y是目标变量

* X是自变量

* β是回归系数

* n是样本数量

* λ是正则化参数

### 3.2 Lasso回归参数估计和正则化参数选择

#### 3.2.1 最小二乘法估计

与岭回归类似,Lasso回归的参数估计也可以

0

0