【进阶篇】基于MATLAB的随机森林分类

发布时间: 2024-05-22 13:13:21 阅读量: 207 订阅数: 198

# 2.1 决策树算法简介

决策树是一种监督学习算法,它通过构建一个树形结构来对数据进行分类或回归。决策树的每个节点表示一个特征,每个分支表示该特征的不同取值。

决策树的构建过程如下:

1. **选择根节点:**从特征集中选择一个最能区分不同类别的特征作为根节点。

2. **递归分裂:**对于每个根节点,根据该特征的不同取值将数据分成不同的子集。然后,对每个子集重复步骤 1,直到满足停止条件(例如,数据纯净或达到最大深度)。

3. **生成决策树:**将上述过程重复,直到所有数据都被分类或回归。

决策树的优势在于其易于理解和解释。它还可以处理高维数据,并能够自动识别重要的特征。

# 2.1 决策树算法简介

决策树是一种监督学习算法,用于解决分类和回归问题。它将数据表示为一个树形结构,其中每个节点代表一个特征,每个分支代表一个决策。决策树算法通过递归地将数据分割成更小的子集来构建树。

### 决策树的构建过程

决策树的构建过程如下:

1. **选择根节点:**从数据集中选择一个特征作为根节点。该特征通常是具有最高信息增益或最低基尼不纯度的特征。

2. **分割数据:**根据根节点的特征值将数据分割成两个或多个子集。

3. **递归构建:**对每个子集重复步骤 1 和 2,直到满足停止条件(例如,数据集中所有样本属于同一类或特征用尽)。

4. **生成决策树:**将所有节点和分支连接起来,形成决策树。

### 决策树的优点和缺点

**优点:**

* 易于理解和解释

* 可以处理高维数据

* 对缺失值不敏感

**缺点:**

* 容易过拟合

* 对噪声数据敏感

* 决策边界可能过于复杂

### 决策树的数学基础

决策树的构建过程基于信息论和概率论。信息增益和基尼不纯度是衡量特征分割效果的两个常用指标。

**信息增益:**衡量特征分割后数据集信息的不确定性减少程度。公式为:

```

IG(S, A) = H(S) - Σ(v ∈ Values(A)) p(v) * H(S_v)

```

其中:

* S 是数据集

* A 是特征

* Values(A) 是 A 的取值集合

* p(v) 是 A 取值为 v 的概率

* H(S) 和 H(S_v) 分别是 S 和 S_v 的信息熵

**基尼不纯度:**衡量数据集的不纯程度。公式为:

```

Gini(S) = 1 - Σ(i = 1 to c) p(i)^2

```

其中:

* S 是数据集

* c 是类别的数量

* p(i) 是第 i 类的概率

# 3.1 MATLAB中随机森林分类的实现

**使用MATLAB实现随机森林分类**

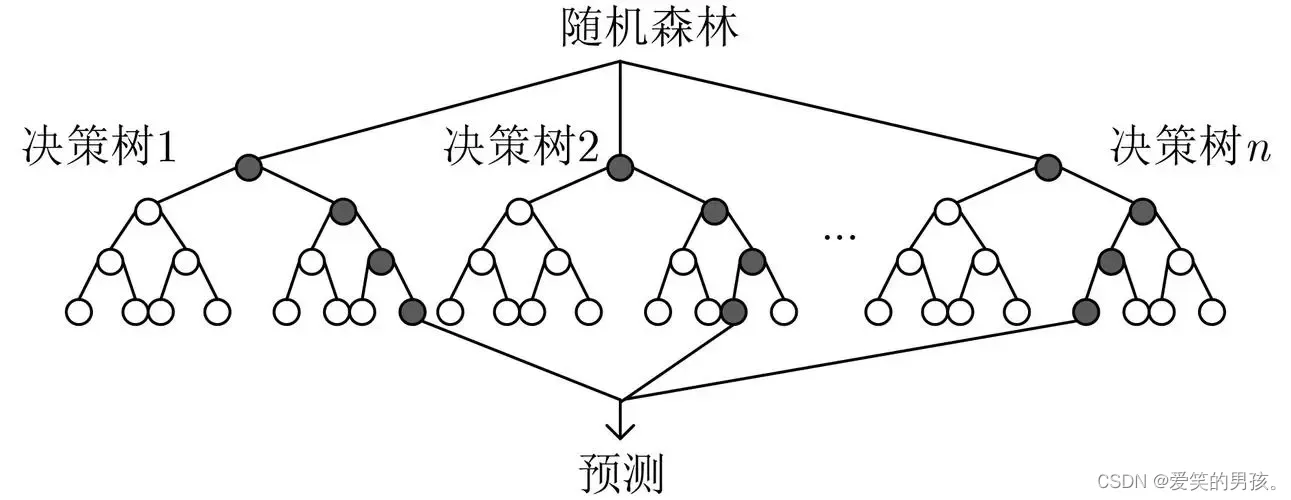

MATLAB提供了内置的TreeBagger类来实现随机森林分类。TreeBagger类是一个封装了多个决策树的集合,每个决策树都是使用不同的训练数据和特征子集训练的。

```

% 加载数据

data = load('data.mat');

X = data.X;

y = data.y;

```

0

0