【进阶篇】MATLAB实现决策树分类的源码

发布时间: 2024-05-22 13:06:44 阅读量: 164 订阅数: 293

Matlab实现决策树算法

# 1. 决策树分类概述**

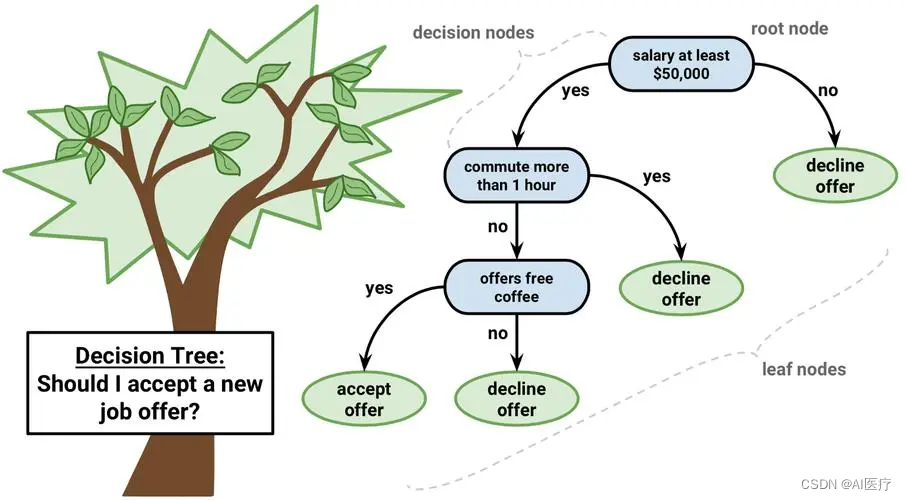

决策树是一种机器学习算法,用于解决分类问题。它以树状结构表示决策过程,其中每个内部节点代表一个特征,每个叶节点代表一个分类结果。决策树分类的优点包括:

* 可解释性强:决策树模型易于理解,可以直观地展示决策过程。

* 鲁棒性好:决策树对缺失值和异常值不敏感,可以处理噪声数据。

* 计算高效:决策树模型的训练和预测过程相对高效,适合处理大数据集。

# 2. MATLAB中的决策树分类

### 2.1 决策树模型的基本原理

决策树是一种机器学习算法,它通过一系列规则将数据点分类或预测目标变量。决策树模型由节点和叶节点组成,其中:

- **节点**表示一个决策点,根据某个特征将数据点分为不同的子集。

- **叶节点**表示决策树的终止点,其中包含最终的分类或预测结果。

决策树的构建过程如下:

1. **选择根节点:**从训练数据中选择一个特征,该特征最能区分不同的类别。

2. **划分数据:**根据根节点特征的值,将数据点分为不同的子集。

3. **递归构建:**对每个子集重复步骤1和2,直到所有数据点都被分类或预测。

### 2.2 MATLAB中决策树分类器的实现

MATLAB提供了`fitctree`函数,用于构建决策树分类器。该函数接受以下参数:

```matlab

fitctree(X, Y, 'PredictorNames', predictorNames, 'ResponseName', responseName, 'MaxNumSplits', maxNumSplits, 'MinLeafSize', minLeafSize)

```

其中:

- `X`:特征矩阵,每一行代表一个数据点,每一列代表一个特征。

- `Y`:目标变量向量,代表每个数据点的类别。

- `PredictorNames`:特征名称的可选单元格数组。

- `ResponseName`:目标变量名称的可选字符串。

- `MaxNumSplits`:最大分裂次数,限制决策树的深度。

- `MinLeafSize`:叶节点中允许的最小数据点数量。

#### 2.2.1 fitctree函数的使用

以下代码演示了如何使用`fitctree`函数构建决策树分类器:

```matlab

% 导入数据

data = readtable('data.csv');

% 特征矩阵和目标变量向量

X = data{:, 1:end-1};

Y = data{:, end};

% 构建决策树分类器

tree = fitctree(X, Y);

% 预测新数据

newData = [10, 20, 30];

prediction = predict(tree, newData);

```

#### 2.2.2 决策树参数的优化

`fitctree`函数允许优化决策树的参数,以提高分类准确性。常用的参数优化方法包括:

- **交叉验证:**将数据分为训练集和测试集,多次构建决策树并评估其性能。

- **网格搜索:**遍历参数值的网格,选择性能最佳的组合。

- **贝叶斯优化:**使用贝叶斯优化算法,高效地搜索参数空间。

以下代码演示了如何使用交叉验证优化决策树参数:

```matlab

% 交叉验证参数

cvp = cvpartition(Y, 'KFold', 10);

% 参数网格

params = {'MaxNumSplits', [5, 10, 15], 'MinLeafSize', [1, 5, 10]};

% 优化参数

```

0

0